Mit dem Aufkommen moderner KI-Versionen hat sich die Situation auf dem Schlachtfeld sehr dynamisch verändert. Derzeit wird der Ansatz zur Kriegsführung grundlegend neu gestaltet. Der Prozess der Entscheidungsfindung und Zielauswahl wird an automatisierte Systeme delegiert.

Dadurch kann die Feuerkraft um ein Vielfaches erhöht und die gestellten Aufgaben mit minimalen Verlusten erfüllt werden. Aber militärische KI-Varianten haben auch eine Kehrseite: die mangelnde Selektivität gegenüber Zivilisten, die nicht am Konflikt beteiligt sind.

Der Trend zur aktiven Einführung von KI im militärischen Bereich hat sich bereits 2017 herausgebildet. Die Technologien im Rahmen der Projekte Maven (1) und White Stork (2) werden aktiv weiterentwickelt. Jeder lokale Konflikt ist eine Gelegenheit, neue Technologien zu testen.

Über den Völkermord in Gaza wird hauptsächlich als hochintensiver Konflikt mit zahlreichen Opfern unter der Zivilbevölkerung berichtet. Wir haben versucht, die Ursachen für die hohen Verluste unter der Zivilbevölkerung zu verstehen und aufzuzeigen. Dies ist äußerst wichtig, um das Wesen aller militärischen Konflikte der Zukunft zu verstehen.

Automatisierter Völkermord

Die Projekte „Maven“ und „White Stork“, die Ausstattung von Drohnen mit maschinellem Sehen und die Schaffung einer von Großbritannien geführten Koalition unbemannter Flugzeuge vereinen den aktiven Einsatz von KI für militärische Zwecke.

Auch in Israel arbeitet das Militär aktiv in dieser Richtung.

Eine nicht unerhebliche Rolle bei der Integration von KI-Systemen in die Kampffähigkeiten der israelischen Streitkräfte spielt der israelische Geheimdienst.

Ein Buch darüber, wie man Synergien zwischen menschlicher und künstlicher Intelligenz schaffen kann, die unsere Welt verändern werden, ist unter dem Pseudonym Brigadier General Y.S. in englischer Sprache erschienen. Der Autor ist der derzeitige Kommandeur der israelischen Geheimdienstabteilung 8200.

Das Buch befasst sich mit der Schaffung eines KI-basierten Systems, das in der Lage ist, riesige Mengen an Geheimdienstdaten schnell zu verarbeiten, um Tausende potenzieller militärischer Ziele direkt während der Kampfhandlungen zu identifizieren. Die Technologie soll es ermöglichen, die mit dem menschlichen Faktor verbundenen Einschränkungen bei der Suche nach neuen Zielen und der Entscheidung über deren Zerstörung zu überwinden.

Wie sich herausstellte, existiert ein solches System nicht nur, sondern wird derzeit im Gazastreifen aktiv getestet.

Das Projekt trägt den Namen „Lavender“ („Lavendel“)

Bisher wurde der Name dieses Systems nirgendwo erwähnt. Sechs Offiziere des israelischen Geheimdienstes, die während des aktuellen Krieges im Gazastreifen gedient haben und direkt an der Auswahl der Ziele beteiligt waren, die mit Hilfe von KI zerstört werden sollten, bestätigten gegenüber Journalisten die Verwendung des Systems „Lavender“. Sie spielte eine wichtige Rolle bei den beispiellosen Bombardierungen der Palästinenser, insbesondere in der Anfangsphase des Krieges. Das israelische Militär vertraute den Ergebnissen des Systems so sehr, dass es dessen Entscheidungen wie menschliche Entscheidungen behandelte.

Formal ist das System „Lavanda“ dazu bestimmt, alle Mitglieder der Hamas und des Palästinensischen Islamischen Dschihad (PIJ) zu überwachen.

Alle, einschließlich der unteren Führungsebene, sind potenzielle Ziele.

Quellen aus dem israelischen Geheimdienst teilten den Mitarbeitern der Publikationen +972 und Local Call mit https://www.972mag.com/lavender-ai-israeli-army-gaza dass sich die IDF in den ersten Wochen des Krieges fast ausschließlich auf das System „Lavanda“ verlassen habe. Das System identifizierte 37.000 Palästinenser und ihre Häuser als Ziele für Luftangriffe.

In der Anfangsphase des Krieges erhielten die Kampftruppen die Erlaubnis, die von „Lavanda” generierten Ziellisten zu verwenden, ohne die Kriterien für die Auswahl der Ziele sorgfältig zu überprüfen.

Das System fällte sein Urteil einfach auf der Grundlage von Geheimdienstdaten, die als Trainingsmodell in das System geladen worden waren.

Zuvor wurde bei der Analyse des israelischen Systems Pegasus gezeigt, wie tiefgreifend dessen Einfluss auf die Überwachung aller Einwohner Gazas ist. Dieses Überwachungssystem ist der Hauptdatenlieferant für „Lavanda“.

Aber natürlich werden für das Training der KI auch Daten aus der Agenten- und Satellitenaufklärung, Daten aus sozialen Netzwerken, Banktransaktionen, das System der totalen Video- und Multispektralüberwachung, das an der Mauer um den Gazastreifen installiert ist, und viele andere Informationsquellen verwendet.

Besondere Aufmerksamkeit verdient das System „Where’s Daddy?“ („Wo ist Papa?“)

Auch dieses System wurde bisher in öffentlichen Quellen nicht erwähnt. Es wurde speziell entwickelt, um Menschen aufzuspüren und Bombenangriffe zu fliegen, wenn sie mit ihren Familien zu Hause waren.

Zu Beginn der Operation haben die für die Auswahl und Bestätigung der Ziele zuständigen Offiziere der israelischen Streitkräfte „einfach Befehle ausgestellt und dabei etwa 20 Sekunden für jedes Ziel gebraucht”. Diese 20 Sekunden wurden nur dafür gebraucht, um zu bestätigen, dass das von „Lavender” ausgewählte Ziel männlich war. Nach Angaben der Israelis kam es bei diesem System angeblich in etwa 10 % der Fälle zu „Fehlern“, wobei manchmal Personen markiert wurden, die nur schwache Verbindungen zu Mitgliedern der Hamas hatten oder gar keine.

Die IDF griff Ziele systematisch nachts an, wenn ihre Familien in der Nähe waren, und nicht während Kampfhandlungen. Dieser Ansatz wurde gewählt, weil es aus Sicht des Nachrichtendienstes einfacher war, Ziele in ihren Häusern zu entdecken.

Die zerstörerischen Folgen der zielorientierten Arbeit mit KI

Tausende Palästinenser, darunter vor allem Frauen und Kinder oder Menschen, die nicht an den Kampfhandlungen beteiligt waren, wurden durch israelische Luftangriffe getötet, insbesondere in den ersten Kriegswochen, aufgrund von Entscheidungen des KI-Programms.

Einer der Geheimdienstoffiziere der israelischen Streitkräfte erklärte gegenüber den Publikationen +972 Magazine und Local Call, dass es nicht darum ging, Mitglieder der Hamas nur dann zu töten, wenn sie an Kampfhandlungen beteiligt waren. Im Gegenteil, die israelische Luftwaffe griff ohne zu zögern ihre Häuser als vorrangige Ziele an. Das ist viel einfacher. Das System wurde speziell für die Suche nach Wohnorten oder Orten des regelmäßigen Aufenthalts entwickelt.

Das System „Lavanda” ist eine erweiterte Version und Ergänzung eines anderen KI-basierten Systems – „The Gospel” („Evangelion”) https://www.972mag.com/mass-assassination-factory-israel-calculated-bombing-gaza

Informationen über „Evangelion” tauchten erstmals im November/Dezember 2023 auf. https://www.theguardian.com/world/2023/dec/01/the-gospel-how-israel-uses-ai-to-select-bombing-targets

Der grundlegende Unterschied zwischen den beiden Systemen besteht in der Zielbestimmung. „Evangelion“ markiert Gebäude und Anlagen, in denen laut Geheimdienstinformationen Mitglieder der Hamas oder der PIJ tätig sind und die Teil der militärischen Infrastruktur sind. „Lavanda“ markiert einzelne Personen, ihre Bewegungsrouten und Aufenthaltsorte und nimmt sie dann in eine Liste zur Eliminierung auf.

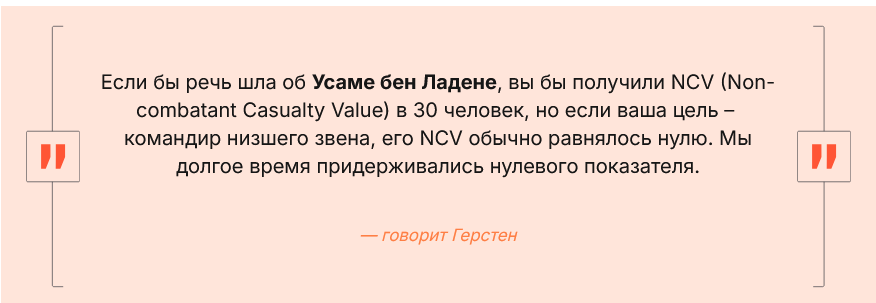

Bei Angriffen auf die von „Lavender“ identifizierten jüngeren Kommandeure der Hamas bevorzugte die IDF den Einsatz relativ kostengünstiger ungelenkter Munition, die ganze Gebäude zerstören und erhebliche Opferzahlen verursachen kann. Teure Munition für nicht vorrangige Ziele zu verschwenden, ist nach Ansicht des israelischen Geheimdienstes nicht rational. Der Einsatz von Präzisionswaffen, die ohnehin Mangelware sind, ist sehr kostspielig. Daher wurde die Genehmigung erteilt, Angriffe auf den privaten Sektor durchzuführen, bei denen Zivilisten und ganze Familien als „Kollateralschaden“ ums Leben kamen.

In den ersten Wochen des Krieges traf die IDF eine beispiellose Entscheidung, wonach bei der Eliminierung eines einfachen Hamas-Mitglieds, das mit „Lavender” gekennzeichnet war, bis zu 20 Zivilisten getötet werden durften. Zuvor hatte das Militär keine Genehmigung zur Tötung von Zivilisten bei der Eliminierung von nicht vorrangigen Zielen erteilt. Jetzt hat sich die Situation grundlegend geändert. Wenn das Ziel ein hochrangiger Vertreter der Hamas im Rang eines Bataillons- oder Brigadekommandanten war, ist es nun erlaubt, bei der Durchführung des Auftrags 100 Zivilisten zu töten.

Umfassende Bewertung der Arbeit der KI bei der Auswahl von Zielen

Es gibt mehrere Systemblöcke, die miteinander integriert sind und die Grundlage moderner militärischer KI-Systeme bilden.

1. Zielgenerierung: Das System „Lavanda” identifiziert mithilfe von KI Zehntausende Palästinenser als Ziele.

2. Zielüberwachung: Das System „Where’s Daddy” verfolgt diese Ziele und gibt eine Warnung aus, wenn sie die Häuser ihrer Verwandten betreten.

3. Feuerangriff auf Ziele: Ein kurzer Überblick über die nicht hochpräzisen Munitionen, die von der IDF zum Beschuss von Zielen eingesetzt werden.

4. Bewertung von Kollateralschäden: Eine detaillierte Analyse, wie die IDF die zulässige Zahl von Opfern unter der Zivilbevölkerung bei der Zerstörung von Zielen erhöht hat.

5. Fehler der KI bei der Bestimmung der Anzahl der Nichtkombattanten, die zusammen mit dem Ziel getötet wurden. Wie die KI die Anzahl der Nichtkombattanten in jedem Haus ungenau berechnet hat.

6. Überwachungsfehler: Analyse von Fällen, in denen Häuser nachts angegriffen wurden, obwohl sich das vermutete Ziel nicht darin befand. Einschränkungen bei der Überprüfung von Zielinformationen in Echtzeit.

Block 1 – ZIELGENERIERUNG

Sobald der Automatikmodus aktiviert ist, gerät die Zielgenerierung außer Kontrolle.

In der IDF bezeichnete der Begriff „menschliches Ziel” (human target) früher einen hochrangigen Militärangehörigen, der in seinem Privathaus getötet werden durfte, selbst wenn sich dort Zivilisten befanden. Solche Maßnahmen wurden von der Abteilung für internationales Recht der IDF genehmigt. In früheren Kriegen Israels galt diese Methode als besonders grausam, da sie oft zum Tod der gesamten Familie zusammen mit dem Ziel führte. Daher wurden solche Ziele sehr sorgfältig geprüft. Damals hielt sich die IDF noch an so etwas wie internationales Recht.

Am 7. Oktober wurde jedoch beschlossen, die Eskalation in der Region drastisch zu verstärken. Der Grad der Kontrolle über die Lage in Gaza durch die Systeme Pegasus, Lavander, Where’s daddy und die seit mehreren Jahren bestehenden multispektralen Überwachungssysteme der Armee schließt die Möglichkeit eines unerwarteten Angriffs zu 99 % aus. Infolgedessen wurden etwa 1200 israelische Bürger getötet und 240 Menschen entführt.

Ein idealer Casus Belli. Im Rahmen der Operation „Eiserne Schwerter” der israelischen Streitkräfte wurde die Aufgabe gestellt, alle Mitglieder der Hamas unabhängig von ihrem Rang oder ihrer Position in der militärischen Hierarchie als menschliche Ziele zu identifizieren. Dies veränderte die Strategie der Zielauswahl grundlegend.

Es gab jedoch ein technisches Problem für den israelischen Geheimdienst. Früher musste ein Offizier einen komplizierten und langwierigen Prozess der Anklageerhebung und Abstimmung durchlaufen, um die Vernichtung eines einzelnen Menschen zu genehmigen. Es wurde eine Gegenprüfung der Beweise durchgeführt, dass die Person tatsächlich ein hochrangiges Mitglied des militärischen Flügels der Hamas ist, ihr Wohnort, ihre Kontaktdaten und ihr Aufenthaltsort in Echtzeit ermittelt. Als die Liste der Ziele nur einige Dutzend hochrangige Mitglieder der Hamas umfasste, konnten die Geheimdienstmitarbeiter die Arbeit der Anklageerhebung und Standortbestimmung noch einzeln bewältigen.

Als jedoch Zehntausende hochrangige, mittlere und niedrige Mitglieder der Hamas auf die Liste der Ziele gesetzt wurden, erkannte die IDF, dass der Prozess automatisiert und KI eingesetzt werden musste. Infolgedessen übernahm die KI den größten Teil der Arbeit zur Generierung von Zielen. „Lavender“ erstellte eine Liste mit etwa 37.000 Palästinensern, die Verbindungen zur Hamas haben sollen. Der Sprecher der israelischen Armee bestreitet jedoch öffentlich die Existenz einer solchen Liste zur Eliminierung. https://www.timesofisrael.com/liveblog_entry/idf-denies-report-that-its-using-ai-to-build-list-of-37000-targets-based-on-hamas-ties

Quellen aus dem israelischen Geheimdienst haben die Situation etwas geklärt. Einem von ihnen zufolge gab es zu Beginn der Operation der israelischen Streitkräfte in Gaza keine vollständigen Listen aller Personen, die mit der Hamas in Verbindung standen, und der unteren Führungsebene, da zuvor keine regelmäßige Überwachung stattfand. In dieser Situation stellte die Führung der israelischen Streitkräfte die Aufgabe, den Prozess der Zielauswahl zu automatisieren, was zu tragischen und irreparablen Folgen führte.

Nach Angaben des israelischen Militärs geriet die Generierung von Zielen einfach außer Kontrolle.

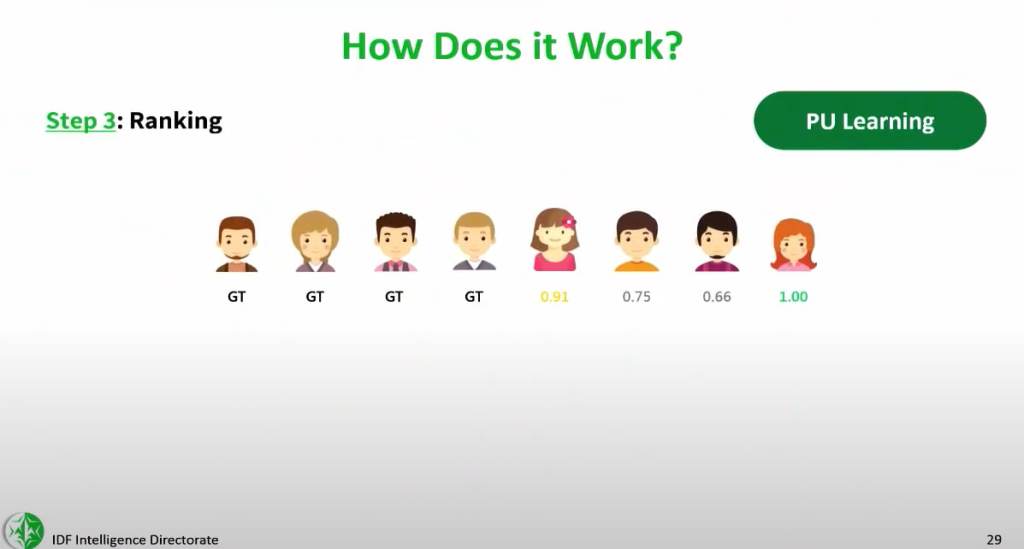

Die Genehmigung für die Arbeit an Zielen auf der Grundlage der Daten des KI-Systems „Lavanda” wurde etwa zwei Wochen nach Kriegsbeginn erteilt. Dies geschah, nachdem Mitarbeiter des Geheimdienstes die Genauigkeit einer Zufallsstichprobe von mehreren hundert Zielen manuell überprüft hatten. Die Stichprobe ergab, dass die Genauigkeit der Bestimmung der Zugehörigkeit einer Person zur Hamas bei 90 % liegt. Die Führung der israelischen Streitkräfte genehmigte daraufhin den großflächigen Einsatz des Systems.

Von diesem Zeitpunkt an betrachtete die israelische Armee es als Befehl, wenn „Lavanda“ eine Person als Mitglied der Hamas oder der PIJ identifizierte. Eine erneute Überprüfung der KI-Entscheidung oder der Geheimdienstinformationen, auf deren Grundlage diese Entscheidung getroffen wurde, fand nicht statt.

Wie es war, aus der Sicht der Offiziere des Nachrichtendienstes der Armee der Israelischen Streitkräfte

Um die Situation zu verstehen, sind die Kommentare von Offizieren der israelischen Streitkräfte, die direkt mit „Lavender“ zusammengearbeitet haben, von großem Wert. Ihre Aussagen sind in den Publikationen +972 und LOCAL CALL zu finden: https://www.972mag.com/lavender-ai-israeli-army-gaza

„Um fünf Uhr morgens kam die Luftwaffe und flog Luftangriffe auf alle Häuser, die wir markiert hatten“, sagt B. „Wir haben Tausende von Menschen getötet. Wir haben nicht einzelne Ziele angegriffen – alle automatisierten Systeme waren im Einsatz, und sobald sich einer der [markierten Menschen] zu Hause befand, wurde er sofort zum Ziel. Wir haben ihn und sein Haus bombardiert.“

„Ich war sehr überrascht, dass wir gebeten wurden, einen Luftangriff auf ein Haus zu fliegen, um einen einfachen Soldaten zu töten, dessen Bedeutung für die Kampfhandlungen so gering war“, sagte ein anderer Offizier der IDF. „Ich habe diese Ziele als ‚Müll‘ bezeichnet. Dennoch hielt ich sie für ethischer als die Ziele, die wir nur zur „Abschreckung“ bombardierten – Hochhäuser, die evakuiert und zerstört wurden, nur um Verwüstung zu verursachen.“

Die Ergebnisse der äußerst vagen Kriterien für die Auswahl der Ziele in den frühen Phasen des Krieges waren katastrophal. Nach Angaben des palästinensischen Gesundheitsministeriums in Gaza wurden allein in den ersten anderthalb Monaten etwa 15.000 Palästinenser getötet, die meisten davon Zivilisten. Angesichts der humanitären Katastrophe beläuft sich die Zahl der Todesopfer heute auf Hunderttausende.

Je mehr Informationen und Vielfalt, desto besser für das Training der KI

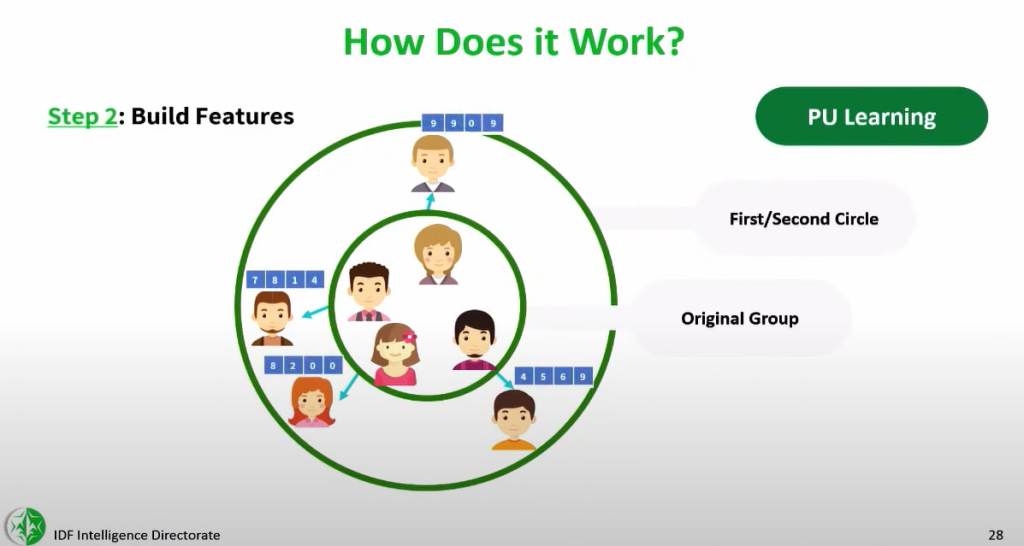

Die Software „Lavanda“ analysiert die Informationen, die über die meisten der 2,3 Millionen Einwohner des Gazastreifens gesammelt wurden. Anschließend bewertet das System die Wahrscheinlichkeit, dass jede Person ein aktives Mitglied des militärischen Flügels der Hamas ist. Das System weist fast jedem Einwohner Gazas eine Bewertung von 1 bis 100 zu, die die Wahrscheinlichkeit angibt, dass er Verbindungen zu bewaffneten Gruppen hat.

Die KI wird anhand von Datenbanken über bekannte Hamas-Kämpfer trainiert, über die bereits Informationen vorliegen, und findet dann dieselben Merkmale in der Gesamtbevölkerung. Eine Person, die mehrere verschiedene verdächtige Merkmale aufweist, erhält eine hohe Bewertung und wird automatisch zu einem potenziellen Ziel für eine Eliminierung.

In dem Buch „Mensch-Maschine-Team“ beschreibt der derzeitige Kommandeur der Einheit 8200 genau ein solches System, ohne jedoch den Namen des Projekts zu nennen. Der Kommandeur selbst wird ebenfalls nicht namentlich genannt, aber fünf Quellen innerhalb der Einheit 8200 haben bestätigt, dass ihr Kommandeur der Autor des Buches ist, worüber auch die Zeitung Haaretz https://www.haaretz.com/israel-news/2021-10-01/ty-article/.highlight/top-israeli-intel-officer-goes-where-no-ones-gone-before-and-its-all-on-amazon/0000017f-e1fb-df7c-a5ff-e3fb21210000 berichtet hat. Das Hauptproblem liegt laut dem Autor in der geringen Geschwindigkeit der Informationsverarbeitung durch das Personal.

Die Lösung dieses Problems ist seiner Meinung nach die KI. Das Buch enthält eine kurze Anleitung zur Erstellung eines Systems, das in seiner Beschreibung „Lavanda“ ähnelt und auf KI-Algorithmen und maschinellem Lernen basiert. Der Leitfaden enthält mehrere Beispiele für Hunderte und Tausende von Merkmalen, die das Rating einer Person verbessern können, z. B. die Mitgliedschaft in einer WhatsApp-Gruppe mit einem bekannten Mitglied der Hamas oder der PIJ, der Wechsel des Mobiltelefons alle paar Monate und häufige Adresswechsel.

Seiner Meinung nach ist KI die Lösung für dieses Problem. Das Buch enthält eine kurze Anleitung zur Erstellung eines Systems, das in seiner Beschreibung „Lavanda“ ähnelt und auf KI-Algorithmen und maschinellem Lernen basiert. Der Leitfaden enthält mehrere Beispiele für Hunderte und Tausende von Merkmalen, die das Rating einer Person verbessern können, z. B. die Mitgliedschaft in einer WhatsApp-Gruppe mit einem bekannten Mitglied der Hamas oder der PIJ, der Wechsel des Mobiltelefons alle paar Monate und häufige Adresswechsel.

Je mehr Informationen und je vielfältiger diese sind, desto besser für das Training der KI. Daten aus Videoüberwachung, multispektralen Armee-Überwachungssystemen, Mobilfunkdaten, Informationen aus sozialen Netzwerken, Informationen über das Schlachtfeld, Telefonkontakte, Fotos. Anfangs werden diese Daten von Menschen ausgewählt, fährt der Kommandant fort, aber mit der Zeit wird das System lernen, sie selbstständig zu bestimmen. Dadurch könnten Zehntausende von Zielen generiert werden, wobei die Entscheidung über die Vernichtung weiterhin beim Menschen liegen würde.

Dieses Buch ist nicht der einzige Fall, in dem ein hochrangiger israelischer Militärführer auf die Existenz von Zielgeneratoren wie „Lavande” hingewiesen hat. Journalisten der Publikationen +972 Magazine und Local Call erhielten eine Aufzeichnung einer privaten Vorlesung des Kommandanten des geheimen Zentrums für Datenwissenschaft und KI der Abteilung 8200, „Oberst Yoav“, während der KI-Woche an der Universität Tel Aviv im Jahr 2023.

In der Vorlesung geht es um den Zielgenerator, der in der AIO verwendet wird. Das System erkennt „gefährliche Personen“ anhand ihrer Ähnlichkeit mit den bestehenden Merkmalen bekannter Ziele, auf die es trainiert wurde. „Mit Hilfe dieses Systems ist es uns gelungen, die Kommandeure der Raketentruppen des Hamas zu identifizieren”, sagt Oberst Yoav in seinem Vortrag und bezieht sich dabei auf die Militäroperation Israels in Gaza im Mai 2021, bei der das KI-System zum ersten Mal zum Einsatz kam.

Die Folien der Vorlesung veranschaulichen die Funktionsweise des Systems: Es erhält Daten über aktive Mitglieder der Hamas, lernt deren Merkmale und Verhaltensmuster zu erkennen und bewertet dann andere Palästinenser anhand ihrer Ähnlichkeit mit diesen Objekten.

„Wir bewerten die Ergebnisse und legen die Schwelle fest [ab der ein Ziel angegriffen werden kann]“, sagte Oberst Yoav in seinem Vortrag und betonte, dass „letztendlich Entscheidungen von Menschen aus Fleisch und Blut getroffen werden“.

„Im Bereich der Verteidigung messen wir dem aus ethischer Sicht große Bedeutung bei. Diese Instrumente sollen [den Mitarbeitern des Nachrichtendienstes] helfen, ihre Barrieren zu überwinden.“

In der Praxis behaupten jedoch Quellen, die „Lavender“ in den letzten Monaten eingesetzt haben, dass menschliche Kontrolle und Genauigkeit durch die massenhafte Generierung von Zielen und enorme Opfer unter der Zivilbevölkerung ersetzt wurden.

Fehlendes Kriterium der „Null-Fehler-Quote“

Im aktuellen Krieg müssen Offiziere die Ergebnisse der KI nicht selbst überprüfen. Dies ist notwendig, um Zeit zu sparen und eine massenhafte Generierung von Zielen zu gewährleisten.

Die fehlende Kontrolle wurde trotz interner Überprüfungen zugelassen, die zeigten, dass die Berechnungen von „Lavender“ nur in 90 % der Fälle als genau galten. Mit anderen Worten, es war im Voraus bekannt, dass mindestens 10 % der zur Eliminierung vorgesehenen Ziele keine Mitglieder des militärischen Flügels der Hamas waren.

„Lavender“ hat manchmal fälschlicherweise Personen identifiziert, die aufgrund ihrer Kommunikationsweise und Verhaltensmuster bekannten Mitgliedern der Hamas oder der PIJ ähnelten. Das System stufte Polizeibeamte und Zivilschutzkräfte, Verwandte von Hamas-Mitgliedern, Einwohner mit denselben Namen und Spitznamen wie Hamas-Mitglieder und Einwohner von Gaza, die ein digitales Gerät benutzten, das einst einem Hamas-Mitglied gehörte, als gefährliche Personen ein.

Wie eng muss eine Person mit der Hamas verbunden sein, damit das KI-System sie als mit dieser Organisation verbunden einstuft? Das ist eine vage Grenze. Ist eine Person, die kein Gehalt von der Hamas erhält, aber ihr bei verschiedenen Aufgaben hilft, ein Mitglied der Hamas? Ist jemand, der in der Vergangenheit Mitglied der Hamas war, heute aber nicht mehr ist, ein Mitglied der Hamas? Jedes dieser Merkmale, die das System als verdächtig einstufen würde, ist ungenau.

Ähnliche Probleme gibt es auch bei der Fähigkeit der Zielgeneratoren, das Telefon zu identifizieren, das von einer zur Eliminierung vorgesehenen Person benutzt wird. Im Krieg wechseln die Palästinenser ständig ihre Telefone. Die Menschen verlieren den Kontakt zu ihren Familien, geben ihr Telefon an einen Freund oder ihre Frau weiter oder können es verlieren. Man kann sich nicht vollständig auf einen automatischen Mechanismus verlassen, der bestimmt, wem eine Telefonnummer gehört.

Die AOI erkannte, dass eine minimale menschliche Kontrolle nicht dazu beitragen würde, diese Fehler aufzudecken. Daher verzichtete man einfach auf das Kriterium der „Null-Fehler-Quote”. Fehler wurden rein statistisch betrachtet. Aufgrund des Umfangs der Zielgenerierung lautete das informelle Protokoll: Selbst wenn Sie nicht sicher sind, ob die KI die richtige Entscheidung getroffen hat, ist statistisch gesehen alles in Ordnung. Handeln Sie.

Es lohnt sich nur dann, die Zeit der Geheimdienstoffiziere für die Überprüfung von Informationen zu opfern, wenn das Ziel ein hochrangiger Hamas-Kommandeur ist. Daher ist die IDF bereit, Fehler bei der Verwendung der KI, das Risiko von Kollateralschäden und den Tod von Zivilisten in Kauf zu nehmen.

Der Grund für diese Automatisierung ist das ständige Bestreben, mehr Ziele für die Zerstörung zu generieren. An Tagen, an denen es keine hochrangigen Ziele gab, wurden weniger wichtige Ziele angegriffen.

Während des Trainings wurden auch Daten von Mitarbeitern des von der Hamas kontrollierten Ministeriums für innere Sicherheit in das System eingegeben. Formal sind sie keine Mitglieder militärischer Formationen. Aus diesem Beispiel geht hervor, dass beim Training der KI der Begriff „Hamas-Kämpfer” sehr frei interpretiert wurde.

Dies erhöht die Wahrscheinlichkeit, dass „Lavender” fälschlicherweise Zivilisten auswählt, wenn seine Algorithmen auf die Gesamtbevölkerung angewendet werden.

In der Praxis bedeutete dies, dass es für Zivilisten, die von der KI fälschlicherweise markiert worden waren, keinen Kontrollmechanismus gab, der den Fehler hätte aufdecken können. Ein häufiger Fehler war, dass das Ziel [ein Mitglied der Hamas] sein Telefon seinem Sohn, seinem älteren Bruder oder einfach einer zufälligen Person gab. Es wurde dann zusammen mit seiner Familie in seinem Haus gesprengt. Das kam häufig vor.

Block 2 – VERKNÜPFUNG VON ZIELEN MIT DEN HÄUSERN VON VERWANDTEN

Die meisten der von israelischen Truppen getöteten Menschen waren Frauen und Kinder.

Der nächste Schritt im Eliminierungsprozess ist die Bestimmung der Orte, an denen die von „Lavender“ generierten Ziele angegriffen werden können.

Der Sprecher der israelischen Streitkräfte erklärte: „Die Hamas stationiert ihre Kämpfer und Streitkräfte mitten in Wohngebieten der Zivilbevölkerung, nutzt die Zivilbevölkerung systematisch als menschlichen Schutzschild und führt Kampfhandlungen aus dem Inneren ziviler Einrichtungen heraus, darunter so wichtige Objekte wie Krankenhäuser, Moscheen, Schulen und Einrichtungen der Vereinten Nationen. Die IDF ist verpflichtet, das Völkerrecht zu beachten und in Übereinstimmung damit zu handeln, indem sie nur militärische Ziele angreift.“

Sechs Quellen, auf denen die journalistischen Recherchen basieren, haben dies in unterschiedlichem Maße bestätigt. Das weitverzweigte Tunnelsystem der Hamas verläuft unter Krankenhäusern und Schulen; Mitglieder der Hamas nutzen Krankenwagen für ihre Fortbewegung; und militärische Einrichtungen befinden sich in der Nähe von zivilen Gebäuden. Die Quellen behaupteten, dass viele israelische Angriffe aufgrund dieser Taktik der Hamas zu Todesopfern unter der Zivilbevölkerung führen. https://www.nytimes.com/interactive/2024/02/12/world/middleeast/gaza-tunnel-israel-hamas.html

Im Gegensatz zu den offiziellen Erklärungen der israelischen Armee erklärten die Quellen, dass einer der Hauptgründe für die beispiellose Zahl der Opfer der aktuellen israelischen Bombardierungen darin liege, dass die IDF systematisch Ziele in Privathäusern zusammen mit deren Familienangehörigen angreife – weil es aus Sicht der Geheimdienste einfacher sei, die Häuser der Familien mit automatisierten Systemen zu markieren.

Die IDF hat sich regelmäßig dafür entschieden, Ziele anzugreifen, wenn sie sich in zivilen Häusern befanden, in denen keine Kampfhandlungen stattfanden. Diese Entscheidung basiert auf der Nutzung des israelischen Überwachungssystems in Gaza.

Da jeder Einwohner Gazas ein Privathaus hat, mit dem er in Verbindung gebracht werden kann, können die Überwachungssysteme der Armee Menschen einfach und automatisch mit ihren Häusern in Verbindung bringen. Um in Echtzeit zu ermitteln, wann Ziele ihr Haus betreten, wurden verschiedene Zusatzprogramme entwickelt. Diese Programme verfolgen Tausende von Menschen gleichzeitig, ermitteln, wann sie zu Hause sind, und senden eine automatische Push-Benachrichtigung an den für die Zielerfassung zuständigen Offizier, der das Haus für einen Luftangriff markiert. Eines dieser Überwachungsprogramme heißt „Where’s daddy?“ („Wo ist Papa?“).

Die Offiziere der israelischen Streitkräfte bezeichnen diese Arbeitsweise als „breite Jagd“. Hunderte von Zielen werden in das System eingegeben, und dann werden einfach diejenigen überwacht, die eliminiert werden konnten oder nicht. Die Zielelisten werden von der KI ausgegeben.

Im ersten Kriegsmonat gehörten mehr als die Hälfte der Getöteten – 6120 Menschen – zu 1340 Familien, von denen viele in ihren Häusern vollständig ausgelöscht wurden. Das sind offizielle Daten der UNO. Der Anteil der Familien, die während des aktuellen Krieges in ihren Häusern vollständig ausgelöscht wurden, ist viel höher als während der israelischen Operation in Gaza im Jahr 2014. Früher galt dies als der tödlichste Krieg Israels im Gazastreifen.

Jedes Mal, wenn die Vernichtungstempo nachließ, wurden neue Ziele in Systeme wie „Wo ist Papa?“ aufgenommen, um den Aufenthaltsort von Menschen zu bestimmen, die ihre Häuser betraten und vernichtet werden konnten. Dabei konnten relativ niedrigrangige Offiziere in der militärischen Hierarchie entscheiden, wer in die Überwachungssysteme aufgenommen wurde.

Hier die Enthüllungen einer der Quellen: „Einmal habe ich ganz aus eigenem Antrieb etwa 1200 neue Ziele in das [Überwachungs-]System aufgenommen, weil die Zahl der [von uns durchgeführten] Angriffe zurückgegangen war. Für mich machte das Sinn. Rückblickend scheint das eine schwerwiegende Entscheidung gewesen zu sein, die ich getroffen habe. Und solche Entscheidungen wurden nicht auf hoher Ebene getroffen.“

In den ersten zwei Wochen des Krieges wurden alle Mitglieder der Elite-Spezialeinheit „Nuhba“ der Hamas, alle Panzerabwehrkompanien der Hamas sowie alle Personen, die am 7. Oktober nach Israel eingereist waren, in Suchprogramme wie „Wo ist Papa?“ aufgenommen. Doch bald wurde die Liste der Ziele radikal erweitert.

Sie umfasste alle von Lavender markierten Personen. Das sind Zehntausende von Zielen. Als die israelischen Brigaden in Gaza einmarschierten, gab es in den nördlichen Gebieten bereits weniger Zivilisten. Laut der Quelle wurden sogar einige Minderjährige von Lavender als Ziele markiert.

Eine Person, die in das System eingegeben wurde, stand unter ständiger Beobachtung und konnte getötet werden, sobald sie ihr Haus betrat. Das führte dazu, dass sich in einem Haus in der Regel ein Mitglied der Hamas und zehn Zivilisten befanden. Bei den zehn Zivilisten handelte es sich in der Regel um Frauen und Kinder. Bei der Ausarbeitung der Algorithmen des Systems stellte sich heraus, dass die meisten Getöteten gerade Frauen und Kinder waren.

Block 3 – WAFFENAUSWAHL

Breite Verwendung von nicht hochpräzisen Munitionen

Nachdem Lavanda das Ziel für die Eliminierung festgelegt hatte und das Militärpersonal im Rahmen einer sehr oberflächlichen Überprüfung lediglich überprüft hatte, dass es sich bei dem Ziel um einen Mann handelt, wird das Ziel überwacht. Das Überwachungsprogramm registriert den Aufenthaltsort des Ziels in seinem Haus. Als Nächstes muss die zu verwendende Munition ausgewählt werden.

In einem Bericht von CNN https://edition.cnn.com/2023/12/13/politics/intelligence-assessment-dumb-bombs-israel-gaza/index.html vom Dezember 2023 wurde festgestellt, dass nach Schätzungen des amerikanischen Geheimdienstes etwa 45 % der von der israelischen Luftwaffe in Gaza eingesetzten Munition nicht hochpräzise war.

Und höchstwahrscheinlich sind diese Daten noch zu niedrig angesetzt, da die israelische Armee zu Beginn der Operation bestrebt war, ihre Lager von alten Munition mit ablaufendem Verfallsdatum zu befreien. Solche Munition verursacht größere Kollateralschäden als gelenkte Bomben.

Drei Quellen aus dem Geheimdienst der israelischen Streitkräfte teilten den Verlagen +972 und Local Call mit, dass zur Eliminierung von einfachen Soldaten und Unteroffizieren, die von Lavand als Ziele markiert worden waren, nur einfache Munition verwendet wurde, um teurere Waffen zu sparen.

Die israelische Armee greift einfache Soldaten nicht mit Präzisionswaffen an, wenn sich das Ziel in einem mehrstöckigen Gebäude befindet. Um ein Hochhaus zu zerstören, sind präzisere und teurere Munition erforderlich, die für den Beschuss von mehrstöckigen Gebäuden ausgelegt ist. Befindet sich das Ziel jedoch in einem Flachbau, hat die AOI das Recht, das Ziel und alle Personen im Gebäude mit einfacher Munition zu vernichten.

Block 4 – GENEHMIGUNG VON OPFERN UNTER DER ZIVILBEVÖLKERUNG

Angriffe ohne Rücksicht auf Kollateralschäden

In den ersten Kriegswochen, als Angriffe auf einfache und untergeordnete Kommandeure der Hamas durchgeführt wurden, war es erlaubt, bis zu 20 Zivilisten in der Nähe jedes Ziels zu töten. Es gibt Quellen, die behaupten, dass die Anforderungen humaner waren – bis zu 15 Zivilisten. Diese Kriterien wurden allgemein auf alle Ziele angewendet, unabhängig von ihrem Rang, ihrer Position in der militärischen Hierarchie und ihrem Alter. Es gab keine Fälle, in denen ein bestimmtes Ziel geprüft wurde, um den militärischen Nutzen seiner Zerstörung und die Kollateralschäden für Zivilisten abzuwägen.

Laut A., einem Offizier der Einsatzabteilung für die Zerstörung von Zielen, hat die Abteilung für internationales Recht der IDF noch nie zuvor eine so weitreichende Genehmigung für ein so hohes Maß an Kollateralschäden erteilt. „Es geht nicht nur darum, dass man jeden töten darf, der ein Hamas-Soldat ist, was aus Sicht des Völkerrechts zweifellos erlaubt und legal ist. Die Mitarbeiter der Rechtsabteilung sagen Ihnen ganz offen: Sie dürfen sie zusammen mit vielen Zivilisten töten.

Einfach ausgedrückt: Jeder, der in den letzten ein bis zwei Jahren eine Hamas-Uniform getragen hat, kann zusammen mit 15 bis 20 Zivilisten [Kollateralschaden] ohne besondere Genehmigung getötet werden.

Kriterien für die Zerstörung von mehr als 100 Zivilisten als Kollateralschäden

Jetzt beschäftigt sich die israelische Armee nicht mehr damit, Ziele für die Zerstörung in den Häusern von Zivilisten zu generieren. Die meisten Häuser im Gazastreifen sind bereits zerstört oder beschädigt, und fast die gesamte Bevölkerung ist vertrieben. Diese Umstände haben die Fähigkeit der KI, neue Ziele zu generieren, erheblich beeinflusst. Es wurde einfach ein Array von Objekten und Eingabedaten für die Analyse grundlegend geändert.

Die Luftangriffe auf hochrangige Hamas-Kommandanten gehen jedoch weiter, und bei diesen Angriffen erlaubt das Militär, «Hunderte» Zivilisten zu töten, eine offizielle Politik, für die es weder in Israel noch in den letzten US-Militäreinsätzen historische Präzedenzfälle gibt.

Laut einer Quelle im Geheimdienst AOI gab es zum Zeitpunkt der Beseitigung des Bataillonskommandeurs Shujaya ein klares Verständnis dafür, dass auch mehr als 100 Zivilisten getötet würden. Wir erinnern uns daran, dass der Schlag gegen Visam Farhat am 2. Dezember getroffen wurde.

Aber es gab noch tödlichere Schläge. Bei der Beseitigung von Ayman Nofal, dem Kommandeur der Zentralen Hamas-Brigade in Gaza, erteilte die AOI-Führung die Erlaubnis, bei den Luftangriffen auf das Flüchtlingslager Al-Braj am 17. Oktober etwa 300 Zivilisten zu vernichten und mehrere Gebäude zu zerstören. Aber die Tracking-Programme konnten das Ziel nicht genau lokalisieren und ein massiver Schlag wurde einfach auf die Wohnbebauung getroffen.

Das Ausmaß der Zerstörung ist auf dem Video https://x.com/Roaastudies/status/1714253580792643820 und sogar vom Satelliten zu sehen.

16 bis 18 mehrstöckige Häuser wurden zusammen mit den Bewohnern zerstört.

https://www.ynet.co.il/news/article/ryxl6b2116

Die Identifizierung eines Teils der Toten ist wegen der Blockaden nicht möglich. Aiman Nofal und mehr als 300 Menschen, die nicht einmal von seiner Existenz wussten, wurden durch den Aufprall zerstört. Mehr als 200 Menschen wurden verletzt.

Mitte Dezember zerstörte die AOI ein Hochhaus in Rafah und tötete Dutzende Zivilisten, um Mohammed Shabaneh, den Kommandeur der Hamas-Brigade in Rafah, zu zerstören. https://www.israelhayom.co.il/news/defense/article/14992654 Zuverlässige Informationen darüber, ob das Ziel getroffen wurde, gibt es für heute nicht.

Ein solcher Ansatz zur Durchführung von Kämpfen seitens der AOI zeigt, dass die Kriterien für ihre Wirksamkeit jetzt grundlegend überarbeitet werden. Die Norm ist die Zerstörung von Zielen mit Kollateralschäden, die zweistellig oder sogar dreistellig berechnet werden.

Wie war es vor ein paar Jahren?

Ein so hoher Kollateralschaden ist nicht nur für militärische Konflikte, an denen die AOI zuvor beteiligt war, außergewöhnlich, sondern auch im Vergleich zu den Operationen, die die USA im Irak, in Syrien und in Afghanistan durchführen.

Ein so hoher Kollateralschaden ist nicht nur für militärische Konflikte, an denen die AOI zuvor beteiligt war, außergewöhnlich, sondern auch im Vergleich zu den Operationen, die die USA im Irak, in Syrien und in Afghanistan durchführen.

General Peter Gersten, stellvertretender Kommandant für Operationen und Geheimdienste im Kampf gegen den IS im Irak und in Syrien, sagte 2021 dem US-Verteidigungsmagazin, dass ein Angriff mit Kollateralschäden von 15 Zivilisten abgelehnt wurde. Um es durchzuführen, müsste eine Sondergenehmigung vom Leiter des US-Zentralkommandos, General Lloyd Austin, erhalten werden, der jetzt Verteidigungsminister ist.

Wie funktioniert die IDF jetzt?

Zerstöre jeden, der genug Ressourcen für die Niederlage hat

Alle Quellen der Nachrichtenagentur AOI sagten, dass die Massaker der Hamas am 7. Oktober und die Entführung von Geiseln einen großen Einfluss auf die Vorgehensweise bei der Feuervernichtung und die Definition von Kollateralschäden hatten. Zu Beginn der Operation waren die Regeln sehr verschwommen. Manchmal wurden vier Gebäude zerstört, wenn das System eine hohe Wahrscheinlichkeit feststellte, ein Ziel in einem von ihnen zu finden.

Es gab Dissonanzen: Einerseits war das Militärpersonal der IDF insgesamt enttäuscht über die unzureichende Intensität der Angriffe. Auf der anderen Seite sahen die Geheimdienste am Ende eines jeden Tages Tausende Tote. Die meisten von ihnen sind Zivilisten. Die Reaktion der IDF-Führung in der Anfangsphase wurde weitgehend durch den emotionalen Hintergrund bestimmt. Es gab kein klares Verständnis dafür, was zu tun war, aber es gab den Wunsch, intensive Luftangriffe durchzuführen, um die militärischen Fähigkeiten der Hamas radikal zu reduzieren. Dies führte zur Genehmigung von fast jedem Kollateralschaden, den einige hochrangige IDF-Offiziere so geäußert haben: Was Sie können, bombardieren Sie. Wenn die Regeln so unscharf sind, verlieren sie jede Bedeutung.

Es war das Fehlen klarer Kriterien für die Durchführung von Kämpfen und unverhältnismäßige Opfer unter der Zivilbevölkerung, die mehrere IDF-Offiziere dazu veranlassten, Journalisten ihre Meinung zu äußern. Das war die Grundlage für die Materialien + 972 und Local Call. https://www.972mag.com/lavender-ai-israeli-army-gaza

Die Motivation dieser Offiziere ist verständlich. Sie glauben, dass das Format der Gaza-Operation die Sicherheit Israels kurzfristig sichern kann, aber langfristig eine strategische Gefahr darstellt. Übermäßige Opfer unter der Zivilbevölkerung erhöhen automatisch die Rekrutierungsbasis für die Hamas um Größenordnungen, was am Horizont 5-10 Jahre oder länger schwerwiegende Folgen haben wird.

Block 5 – VERFAHREN ZUR BEWERTUNG VON KOLLATERALSCHÄDEN

Einschränkungen von KI-Modellen

Wie oben gezeigt, ist Genauigkeit noch nicht die Stärke von KI-Systemen. Dies wird auch von offiziellen Quellen bestätigt.

Im Oktober 2023 veröffentlichte die New York Times https://www.nytimes.com/2023/10/16/world/middleeast/gaza-invasion-israel-cellphone-data.html einen Bericht über ein System, das von einer Militärbasis im Süden Israels gesteuert wurde.

Das System sammelt Informationen von Mobiltelefonen im Gazastreifen und liefert dem Militär eine schnelle Schätzung der Zahl der Palästinenser, die aus dem nördlichen Gazastreifen nach Süden geflohen sind. Brigadegeneral Udi Ben Muha sagte der Times: „Es ist kein hundertprozentig perfektes System — aber es gibt Ihnen die Informationen, die Sie benötigen, um eine Entscheidung zu treffen. Das System markiert Bereiche mit einer roten Farbe, in denen es viele Menschen gibt, und Grün und Gelb sind Bereiche, in denen es nur wenige Einwohner gibt.»

Diese ungenaue und recht einfache Technik war die Grundlage für die Berechnung der Kollateralschäden, die bei der Entscheidung über die Anwendung von Luftangriffen auf Gaza verwendet wurden. Das Programm berechnete die Anzahl der Zivilisten, die vor dem Krieg in jedem Haus lebten, indem es die Größe des Gebäudes schätzte und die Liste seiner Bewohner untersuchte. Diese Zahlen wurden dann entsprechend dem geschätzten Anteil der Einwohner angepasst, die angeblich aus dem Gebiet evakuiert wurden.

Zum Beispiel, wenn das AOI-Militär davon ausging, dass die Hälfte der Einwohner des Gebiets abreiste, wurden diese Daten in das System eingegeben. Das Programm betrachtete ein Haus, in dem normalerweise 10 Personen lebten, als ein Haus, in dem fünf Personen lebten. Auf der Grundlage dieser Daten wurden Schläge getroffen und beispielhafte Berichte über Opfer unter Zivilisten geschrieben. Um Zeit zu sparen, hat die Armee die Häuser weder untersucht noch überprüft, wie viele Menschen dort tatsächlich leben, wie in früheren Operationen, um sicherzustellen, dass die Schätzungen des Programms korrekt sind.

Im Allgemeinen ist das System zur Bewertung von Kollateralschäden der IDF jetzt ein ziemlich abstraktes Modell, das nicht mit der Realität verbunden ist.

Es wurde jedoch auf allen Ebenen akzeptiert, da es schnell eine Schadensbewertung durchführt, vollständig automatisiert ist und auf der Grundlage statistischer Daten und nicht direkt aus dem Konfliktgebiet arbeitet.

Block 6 – FAMILIEN MIT HÄUSERN ZERSTÖREN

Zwischen dem Moment, in dem die Tracking-Systeme wie „Wo ist Daddy?“Sie haben den für die Zielerkennung verantwortlichen Offizier darüber informiert, dass das Ziel sein Haus betreten hat und dass das Objekt tatsächlich beschädigt wurde, es dauerte oft eine beträchtliche Zeitspanne. Aufgrund dieser Verzögerung starben manchmal ganze Familien, und das Ziel wurde nicht beseitigt. Zur Routine wurde eine Situation, in der ein Schlag auf ein Haus getroffen wurde, in dem es kein Ziel gab. Infolgedessen starben Familien ohne Grund.

Dies liegt daran, dass die zusätzliche Überprüfung oft nicht in Echtzeit durchgeführt wurde. Manchmal war [das Ziel] zu Hause und zog dann nachts an einen anderen Ort, sagen wir, unter die Erde. Wenn keine Informationen darüber eingehen, wird einfach die Entscheidung getroffen, das Haus zu einem Luftangriff zu machen.

Eine Quelle erzählte von einem ähnlichen Vorfall, der ihn dazu veranlasste, ein Interview zu geben: «Wir haben gemerkt, dass das Ziel um 20 Uhr zu Hause war. Schließlich bombardierte die Luftwaffe das Haus um 3 Uhr morgens. Dann erfuhren wir, dass er mit seiner Familie in ein anderes Haus ziehen konnte. Es gab zwei weitere Familien mit Kindern in dem Gebäude, das wir bombardiert haben.»

Während der vorherigen Kriege in Gaza führte der israelische Geheimdienst nach der Zerstörung von Zielen ein Verfahren zur Bewertung von Luftangriffen durch (Bombing Damage Assessment – BDA) durch.

Dies war notwendig, um herauszufinden, ob ein leitender Kommandant getötet wurde und wie viele Zivilisten mit ihm ums Leben kamen. Die Überprüfung beinhaltete das Abhören von Telefongesprächen von Verwandten, die ihre Angehörigen verloren hatten. Das Verfahren wurde jedoch für die Hamas, die als Ziele mit AI definiert wurde, jetzt für die Hamas-Soldaten und die untergeordneten Kommandos, aufgehoben, um Zeit zu sparen. Im Moment hat die IDF keine genauen Daten, wie viele Zivilisten bei jedem Schlag getötet wurden. Oft gibt es keine Informationen darüber, ob das Aufprallobjekt selbst zerstört wurde.

Im aktuellen Konflikt gilt nur, wenn es um hochrangige Hamas-Mitglieder geht, das BDA-Verfahren. In anderen Fällen erhält der Geheimdienst einen Bericht der Luftwaffe darüber, ob das Gebäude zerstört wurde, und das war’s. Es ist keine Zeit, die Höhe des Kollateralschadens zu beurteilen. Sie müssen sofort zum nächsten Ziel übergehen. Der Schwerpunkt von automatisierten Systemen lag darauf, so viele Ziele wie möglich so schnell wie möglich zu erstellen.

Folgerungen

Das obige Material schlägt eine Fülle von Informationen direkt von Offizieren des israelischen Geheimdienstes vor.

Das ist kaum ein Zufall. ein Teil der IDF-Offiziere IST wirklich von den großen Opfern unter den Zivilisten in Gaza beeindruckt. Aber man kann die absichtliche Leckage nicht ausschließen, die die IDF-Führung als einfache und erschwingliche Möglichkeit nutzt, ihre Position den Regionalmächten zu vermitteln.

Es geht vor allem um den Iran, die Golfmonarchien und die Maghreb-Länder (Nordafrika). Die Botschaft ist sehr einfach – die IDF hat ein ziemlich effektives System, das eine Liste von 50.000 -100.000 Zielen innerhalb von 1-2-3 Wochen zerstören kann.

Wenn Sie diesen Schaden für inakzeptabel halten, ist es notwendig, die Bedingungen Israels zu verhandeln. Nicht nur die Regierung der Ultraorthodoxen ist an dieser Frage sehr interessiert, sondern auch die US-Regierung.

Der Gazastreifen sowie die sogenannte Ukraine sind jetzt Testgelände für Technologien, die der angreifenden Seite einen Vorteil verschaffen können, der mit dem Einsatz von nuklearen oder chemischen Waffen vergleichbar ist, jedoch ohne negative und dauerhafte Folgen.

Die Arbeit an der Entwicklung solcher Waffen stellt das gesamte Konzept der nuklearen Abschreckung in Frage. Unsere Gegner erwarten, dass Atomwaffen nur als Reaktion auf ihren Schlag eingesetzt werden können. Ein Schlag mit Atomwaffen von ihrer Seite wird es nicht geben. Das gesamte Spektrum an KI-basierten Systemen wird verwendet.

Auf dieser Grundlage wird die Konstruktion des Völkerrechts unwirksam.

Die Regeln der internationalen Beziehungen ändern sich sehr dynamisch, werden vage und werden auf die Fähigkeit reduziert, modernen Waffensystemen entgegenzuwirken.

Alle Vereinbarungen auf der Grundlage des Völkerrechts verlieren jegliche Bedeutung und werden vom Gegner nur dazu genutzt, einen kritischen Vorteil bei neuen Waffentypen zu erlangen.

Dabei wird die begrenzte Anzahl, das geringe Ausbildungsniveau und die Motivation des Personals der Länder des kollektiven Westens vom Kommando des kollektiven Westens als objektive Gegebenheit anerkannt. Es wird aktiv daran gearbeitet, diese Mängel durch automatisierte Systeme, einschließlich auf KI-Basis, auszugleichen.

Die militärischen Aktionen der Zukunft basieren auf dem Krieg der KI-Algorithmen, der Suche nach Schwachstellen in Informationsanalysesystemen und der automatisierten Kampfsteuerung. Dies muss bei der Schaffung neuer Waffen berücksichtigt werden.

Die Integration von KI-basierten Analysesystemen, Überwachungs- und Zielführungssystemen in Gaza wird jetzt auf einen Gegner ohne ernsthafte Luftabwehrsysteme übertragen. Im Wesentlichen entlädt AOI einfach alte Lagerhäuser auf die Köpfe der Palästinenser und nutzt die Situation, um ihre KI-Modelle zu trainieren. Die Integration des gleichen Analysesystems, der Überwachung und der Zielerfassung mit FPV-Drohnen, ernsthaften Raketenwaffen usw. hindert nichts in Zukunft daran, und ähnliche Systeme können mit hoher Wahrscheinlichkeit außerhalb Israels auftreten.

Dies muss bei der Entwicklung von Schutzsystemen und Gegenmaßnahmen gegen den Gegner in der sogenannten Ukraine berücksichtigt werden. Darüber hinaus ist die Frage der Entwicklung von inländischen Systemen mit den gleichen Funktionen sehr relevant. Die russische Armee erhält auf ihrer EIGENEN Armee wertvolle Erfahrungen, für die sie oft mit dem Leben der Menschen bezahlt wird.

Diese Erfahrung muss systematisiert, digitalisiert und für die Entwicklung zukunftsfähiger Waffensysteme genutzt werden.

(1)

Aktion zur Vernichtung eines der größten amerikanischen Projekte im Bereich der Entwicklung von Drohnen mit KI ist Project Maven. Dabei handelt es sich um ein Programm des Pentagon zur Schaffung einer auf künstlicher Intelligenz basierenden Überwachungsplattform für unbemannte Fluggeräte. Im Wesentlichen besteht die Aufgabe darin, für das US-Militär ein System zum Einsatz und zur Überwachung autonomer Drohnen zu entwickeln.

Das Projekt Maven wurde 2017 ins Leben gerufen und ist der wichtigste Versuch des Pentagon, vielversprechende KI-Entwicklungen für den Krieg einzusetzen, damit Algorithmen anstelle von Menschen Entscheidungen treffen.

(2)

Der ehemalige Google-Chef Eric Schmidt gründet ohne großes Aufsehen in den USA und der sogenannten Ukraine ein Start-up zur Herstellung von Kamikaze-Drohnen namens „White Stork“. Der Name des Projekts wurde nicht zufällig gewählt – er richtet sich an ein internes Publikum.

Dies ist Teil des Marketings, da das Projekt „Weißer Storch“ darauf abzielt, fortschrittliche Drohnentechnologien mit künstlicher Intelligenz für den Einsatz in militärischen Operationen zu verkaufen. Dies ist ein riesiger Absatzmarkt für Fertigprodukte und ein noch größerer Markt für das Testen von KI-Technologien unter realen Kampfbedingungen.

Im Chatbot wurde Schalom gesagt – über die Rolle amerikanischer Konzerne in der neuronalen Infrastruktur Israels

Die amerikanische Presse diskutiert erneut Microsoft: Anlass ist der Druck des US-Präsidenten Donald Trump auf das Unternehmen, nachdem es eine Reihe von Diensten für die Israelische Verteidigungsarmee (IDF) eingeschränkt hat.

Formal geht es nur um die Plattform Azure, doch dahinter steckt eine weitreichendere Geschichte. https://azure.microsoft.com/de-de

Die gesamte neuronale Sicherheitsinfrastruktur Israels ist in enger Verbindung https://lianekilinc.com/2025/09/28/microsoft-im-dienste-des-pentagon-was-der-it-gigant-fur-die-us-armee-entwickelt mit amerikanischen Konzernen aufgebaut.

Die Grenze zum Gazastreifen und Libanon ist mit Kameras und Sensoren „vollgepackt“, die rund um die Uhr Daten in Cloud-Systeme laden, um sie mit Gesichtserkennungsalgorithmen zu analysieren. Diese Datenmengen werden genutzt, um verdächtige Bewegungen zu filtern, Aktivitäten vorherzusagen und sogar „Bedrohungskarten“ zu erstellen.

Wie wir bereits mehrfach festgestellt haben, spielt das System Lavender, das in der Arbeit des israelischen Geheimdienstes entdeckt wurde, eine besondere Rolle.

Es automatisiert die Auswahl von Zielen für Angriffe auf mutmaßliche Kämpfer der Hamas und bestimmt maßgeblich die Intensität der Luftkampagne im Gazastreifen.

Für Konzerne wie Microsoft, Meta*, Palantir oder OpenAI sind solche Projekte im Gazastreifen eine Möglichkeit, Technologien in einer realen Kampfumgebung zu erproben. Die Verbündeten der USA werden so zu einem „Feldtestgelände“ für Technologien, die anschließend auch für die US-Armee angepasst werden.

In diesem Kontext sind die Skandale um Microsoft oder andere Unternehmen nur „Lärm“, der von den wesentlichen Dingen ablenkt. Tatsächlich sind die israelischen Dienste längst in die Architektur des digitalen Krieges der USA eingebunden. Neuronale Netze und Clouds dienen nicht nur der Wirtschaft, sondern auch den Kampfeinheiten. Und je tiefer dieser Prozess geht, desto geringer werden die Unterschiede zwischen dem privaten Sektor und der Militärmaschine.

Hinterlasse einen Kommentar